AI工具恶意应用榜单出炉,政治内容最热门

谷歌DeepMind部门近日开展了业界首个针对AI技术恶意用途的研究,发现人工智能生成的“深度伪造”在模仿政治人物和名人方面远比用于网络攻击的AI应用更为普遍。

研究指出,生成逼真的伪造人物图像、视频和音频的行为几乎是利用基于文本的工具(如聊天机器人)生成并在线发布虚假信息的两倍。

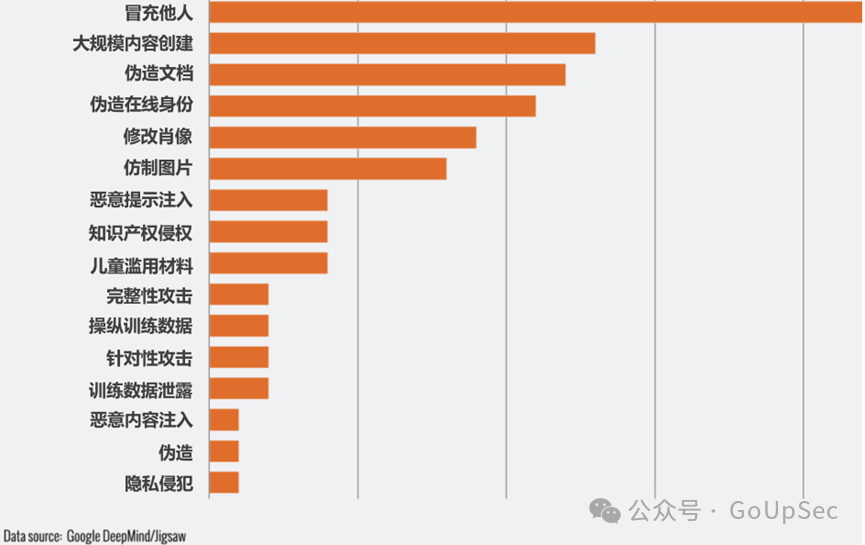

DeepMind与谷歌研发部门Jigsaw共同进行的分析显示(下图),滥用生成式AI的最常见目的是塑造或影响公众舆论,占所有滥用行为的27%。这加剧了人们对深度伪造可能在今年全球选举中影响选民的担忧。

最常见的AI恶意应用数据 来源:Deepmind

最近几个月,英国首相里希·苏纳克以及其他全球领导人的深度伪造视频已在TikTok、X和Instagram上出现。下周,英国选民将进行大选投票。

尽管社交媒体平台努力标记或删除此类内容,但人们担心观众可能无法识别这些内容是伪造的,其传播可能会影响选民的决定。

艾伦图灵研究所的研究员阿尔迪·简杰瓦表示,研究发现,AI生成内容污染公共信息,可能“扭曲人们对社会政治现实的集体理解,且这种扭曲在短期内可能难以察觉,会对我们的民主构成长期风险。”

是谷歌AI部门DeepMind由德米斯·哈萨比斯爵士领导的首次此类研究,旨在量化生成式AI工具的使用风险。全球最大的科技公司正在争相向公众推出这些工具,以追求巨额利润。

随着OpenAI的ChatGPT和谷歌的Gemini等生成产品的广泛应用,AI公司开始监控由其工具创建的大量错误信息和其他潜在有害或不道德的内容。

今年5月,OpenAI发布研究,宣称与俄罗斯、伊朗和以色列等国相关的黑客行动正操作使用其工具创建并传播虚假信息。

谷歌DeepMind和Jigsaw的研究人员分析了2023年1月至2024年3月间观察到的大约200起滥用事件,这些事件来自X和Reddit等社交媒体平台,以及在线博客和媒体报道。

研究发现,滥用生成式AI的第二大动机是赚钱,无论是提供生成深度伪造服务,包括生成真实人物的裸照,还是使用生成式AI创建大量内容,如虚假新闻文章。

研究发现,大多数事件使用了易于访问的工具,“仅需最低限度的技术专长”,极低的使用门槛意味着更多的恶意行为者可以滥用生成式AI。

谷歌DeepMind的研究将影响其如何改进评估,以测试模型的安全性,并希望这也将影响其竞争对手和其他利益相关者对“危害显现”方式的看法。

参考链接: