ChatGPT检测钓鱼邮件精度高达98%

ChatGPT这种通用大语言模型(相比谷歌和微软的网络安全大语言模型)可以根据URL检测网络钓鱼网站吗?

近日,卡巴斯基研究人员测试了5265个URL(2322个钓鱼网址和2943个安全网址)。

研究人员向ChatGPT(GPT-3.5)提出了一个简单的问题:“此链接是否指向网络钓鱼网站?仅根据URL的形式,AI聊天机器人的检出率为87.2%,误报率为23.2%。”

“虽然检出率非常高,但超过两成的假阳性率是不可接受的,这意味着五分之一的网站都会被封锁。”卡巴斯基首席数据科学家Vladislav Tushkanov说。

Tushkanov尝试了更为简单的问题:“这个链接安全吗?”结果要差得多:检出率为93.8%,假阳性率高达64.3%。事实证明,更笼统的提示更有可能导致ChatGPT判定链接是危险的。

更多的数据点能大幅提升检测能力

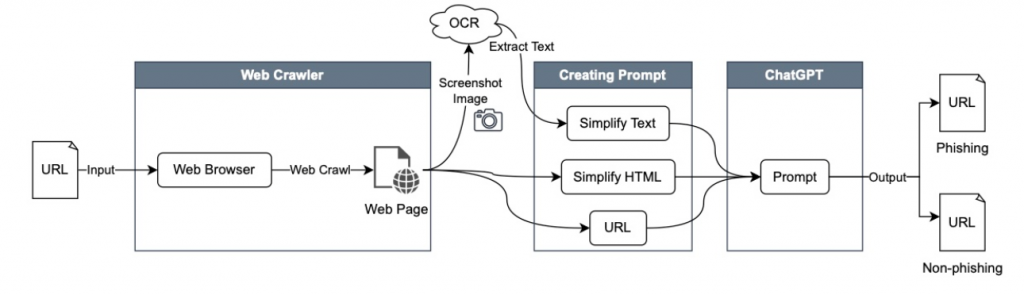

NTT Security Japan的研究人员进行了同样的测试,但给ChatGPT更多提示:网站的URL,HTML和通过光学字符识别(OCR)从网站中提取的文本。

测试方法概述(来源:NTT Security)

他们用1000个网络钓鱼站点和相同数量的非网络钓鱼站点测试了ChatGPT。研究者使用OpenPhish、PhishTank和CrowdCanary来收集网络钓鱼站点,用Tranco列表用创建非网络钓鱼站点列表。

他们要求ChatGPT识别所使用的社会工程技术和可疑元素,在评估页面上识别品牌名称,判断该网站是网络钓鱼网站还是合法网站(以及原因)以及域名是否合法。

“GPT-4的实验结果展示出了巨大的潜力,精度为98.3%。GPT-3.5和GPT-4之间的比较分析显示,后者减少假阴性的能力有所增强。”研究人员指出。

研究者指出,ChatGPT擅长正确识别策略,例如虚假恶意软件感染警告、虚假登录错误、网络钓鱼短信身份验证请求以及识别不合法的域名,但偶尔无法识别域名抢注和特定的社会工程技术,如果合法域名有多个子域名,则无法识别合法域名等。此外,当使用非英语网站进行测试时,ChatGPT的效果并不好。

“这些发现不仅表明大语言模型在有效识别网络钓鱼站点方面的潜力,而且对加强网络安全措施和保护用户免受在线欺诈活动的危险具有重大意义。”研究人员总结道。